7月24日 字節(jié)跳動(dòng)今日正式推出端到端同聲傳譯模型Seed LiveInterpret 2.0。該模型主打中英雙向互譯,其翻譯準(zhǔn)確率與響應(yīng)延遲均接近專(zhuān)業(yè)人類(lèi)同傳譯員水平。

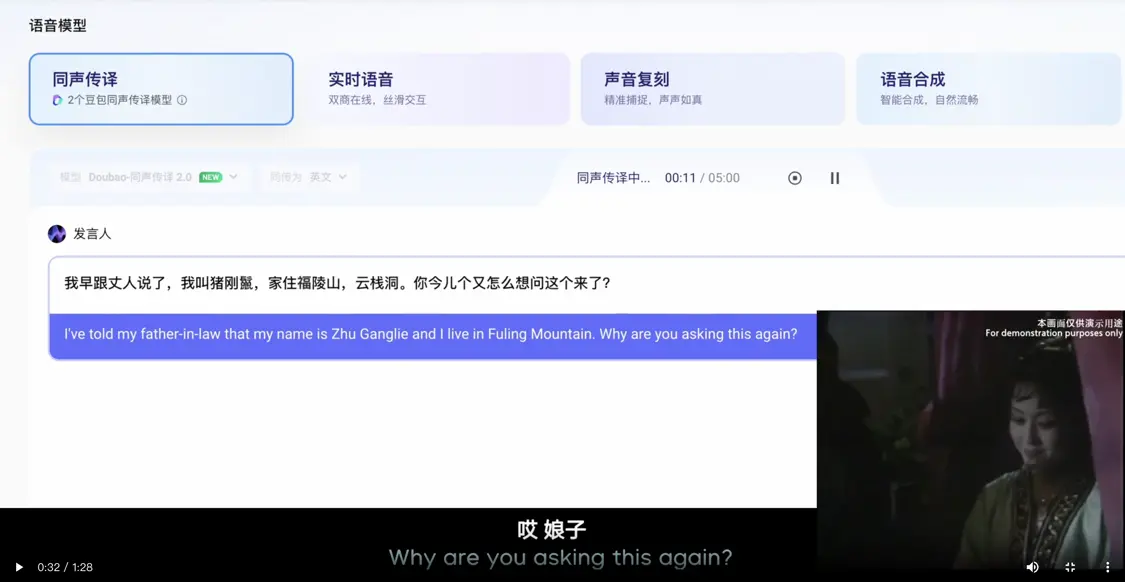

Seed LiveInterpret 2.0基于全雙工語(yǔ)音生成理解框架,能夠?qū)崟r(shí)處理語(yǔ)音輸入并幾乎同步輸出目標(biāo)語(yǔ)言翻譯。

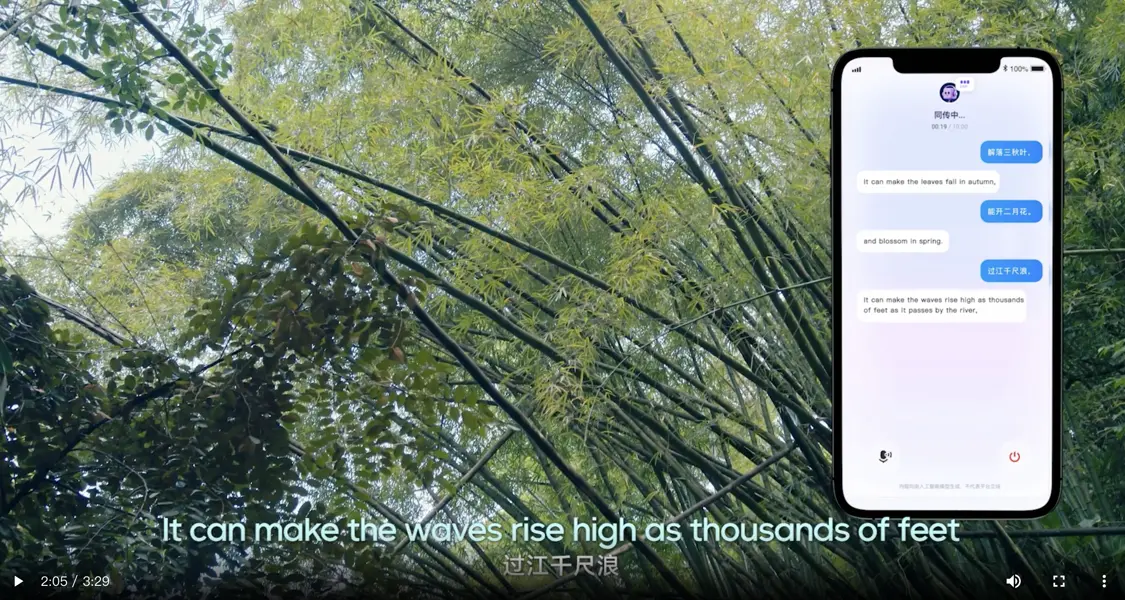

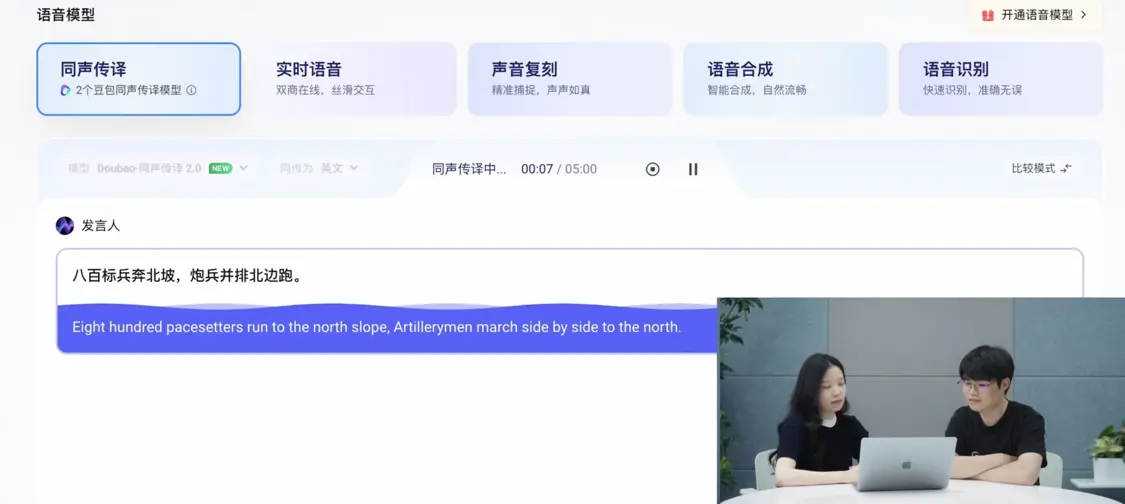

官網(wǎng)展示Seed LiveInterpret 2.0使用過(guò)程

該模型實(shí)現(xiàn)了平均2-3秒的語(yǔ)音到語(yǔ)音延遲,具備實(shí)時(shí)模仿不同說(shuō)話(huà)人音色以保留身份特征的能力,并支持對(duì)上下文、文化背景及包括繞口令、詩(shī)詞、美食文化在內(nèi)的復(fù)雜表達(dá)的理解與互譯。

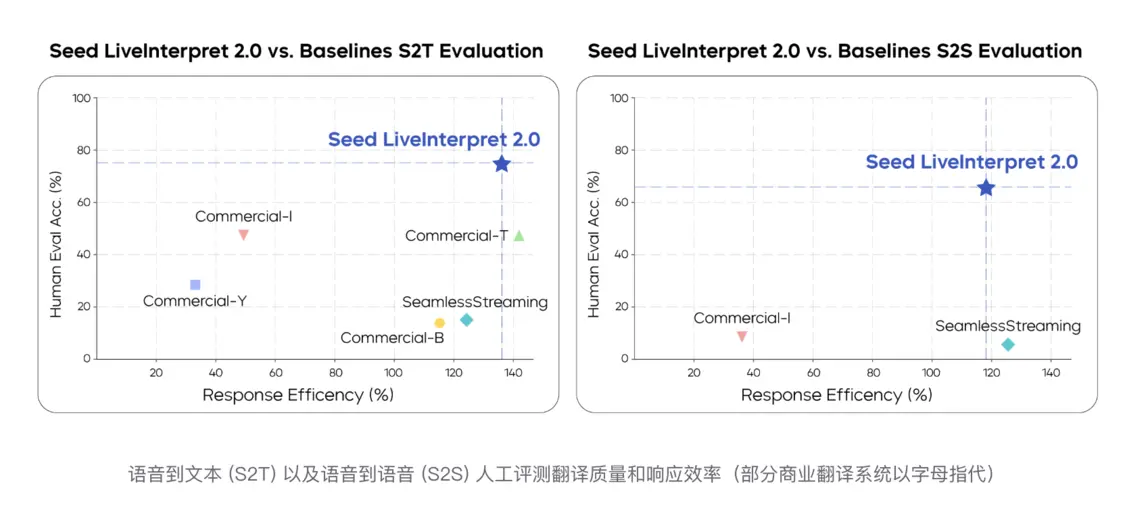

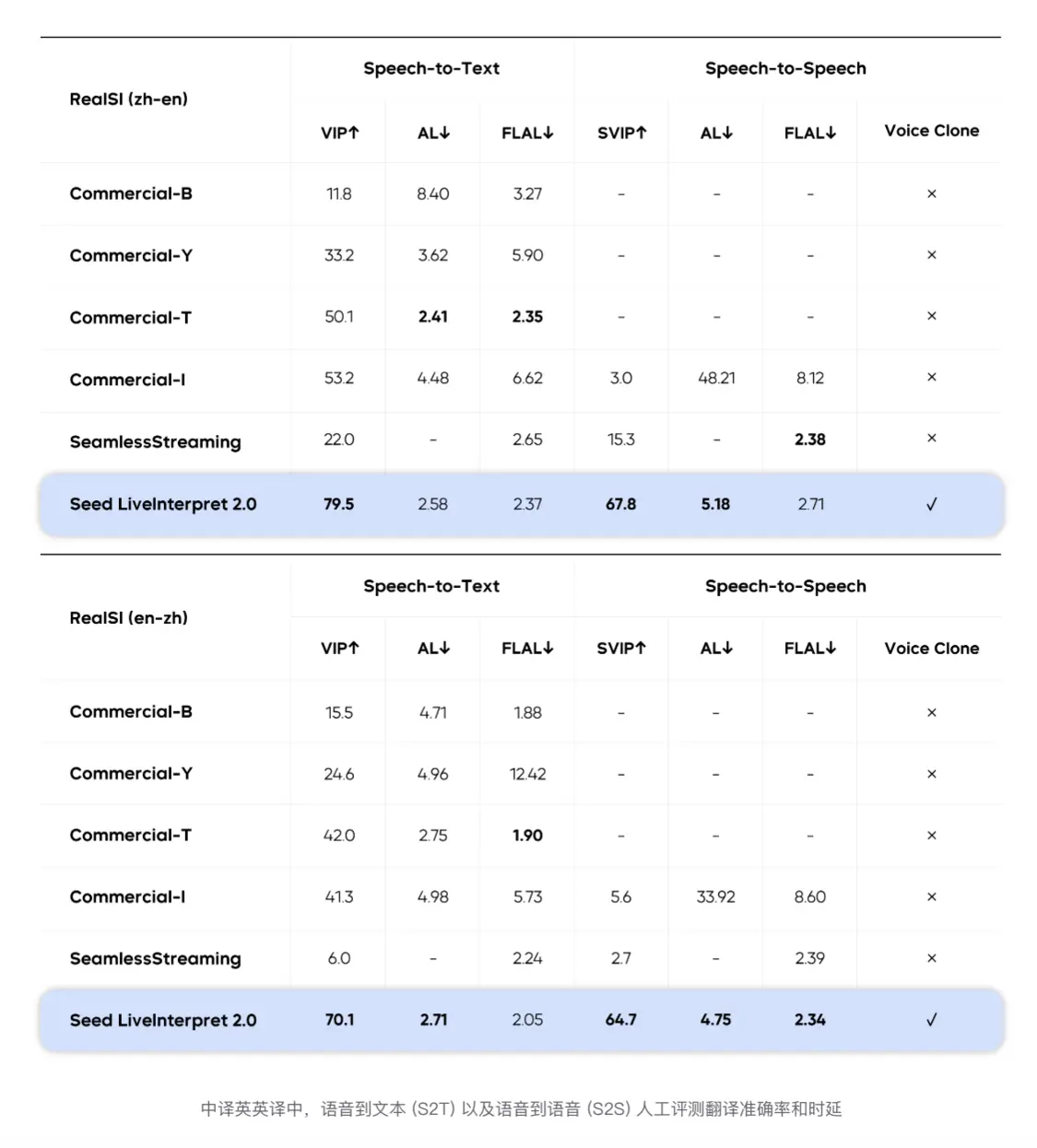

模型測(cè)評(píng)顯示,在語(yǔ)音到文本同傳任務(wù)中,其中英互譯質(zhì)量評(píng)分為74.8(滿(mǎn)分100),領(lǐng)先第二名系統(tǒng)58個(gè)百分點(diǎn)。在更難的語(yǔ)音到語(yǔ)音任務(wù)中(業(yè)界僅3家支持),其綜合質(zhì)量得分達(dá)66.3分,同樣遠(yuǎn)超基準(zhǔn)系統(tǒng)。同時(shí),該模型在語(yǔ)音到文本和語(yǔ)音到語(yǔ)音場(chǎng)景下的首字/首音輸出延遲分別僅為2.21秒和2.53秒。